Les experts de Sensei partagent les points à retenir du guide d’invite d’OpenAI et proposent des conseils pour éviter les problèmes éthiques lors de l’utilisation de ChatGPT.

OpenAI publie un guide rapide pour ChatGPT

Nous avons reçu un cadeau de vacances en décembre lorsque OpenAI a publié un guide rapide pour ChatGPT et d’autres grands modèles linguistiques. Il y a une richesse de connaissances dans le guide. Ce qui suit sont quelques exemples qui ne manqueront pas de « améliorer votre jeu » lorsque vous utilisez ChatGPT.

Assurez-vous de donner des instructions claires

Ajoutez des détails à votre requête pour obtenir de bonnes réponses. Exemple : « J’écris un article destiné aux avocats sur la manière d’éviter d’avoir des problèmes éthiques lors de l’utilisation de l’IA : que dois-je suggérer ? » Vous pouvez indiquer à ChatGPT la durée pendant laquelle vous souhaitez que la sortie dure. Vous pouvez également fournir des exemples de ce que vous recherchez – ou attribuer à ChatGPT un rôle spécifique, par exemple « Vous êtes un expert en éthique juridique ».

Fournissez des textes de référence et divisez les tâches complexes en sous-tâches

Demandez à ChatGPT de répondre en fonction d’un texte auquel vous faites référence. Vous pouvez également lui demander de répondre avec des citations d’un texte de référence.

Les tâches complexes, comme vous pouvez l’imaginer, ont des taux d’erreur plus élevés que les tâches plus simples. Vous pouvez souvent éviter les erreurs en divisant une tâche complexe en une série de tâches. Des instructions supplémentaires peuvent être trouvées dans le guide.

Donnez à ChatGPT « le temps de réfléchir »

Cela semble un peu étrange, n’est-ce pas ? L’IA a tendance à commettre davantage d’erreurs lorsqu’elle tente de répondre immédiatement. Mais vous pouvez demander à ChatGPT de réfléchir étape par étape avant de répondre à votre demande. Le guide contient une explication détaillée sur la façon de procéder.

Pour mémoire, même si nous avons utilisé ChatGPT, nous ne nous sommes pas encore retrouvés dans une situation où nous devions donner à ChatGPT le temps de réfléchir.

Le guide comporte une longue section à ce sujet, suggérant que vous utilisiez d’autres outils, tels que des systèmes de recherche de texte ou des programmes d’exécution de code, qui rendent alors l’IA plus puissante que les modèles de langage pur.

Il est plus utile pour les avocats d’évaluer les invites que vous utilisez beaucoup par le biais d’évaluations ciblées pour évaluer la qualité. Les résultats peuvent être évalués par des personnes, des ordinateurs ou les deux. OpenAI propose un logiciel open source appelé Evals pour cette tâche.

Encore une fois, du point de vue de l’avocat moyen, cela n’est peut-être pas nécessaire. Les auteurs n’ont pas rencontré beaucoup de difficulté à déterminer quand nos invites sont erronées ou à trouver comment obtenir des réponses meilleures, plus utiles et plus réactives. Nous sommes précis et détaillés :

Si vous avez besoin d’une liste (par opposition à un article), demandez-en une. Il est utile d’indiquer le but de l’enquête. Précisez la juridiction pertinente qui vous intéresse. Vous pouvez demander dans l’invite pour vous assurer que la réponse est conforme aux exigences légales et éthiques.

Suggestion d’invite de bonus

Demandez à ChatGPT : « Quels sont les meilleurs conseils d’ingénierie rapide pour les avocats ? Si vous avez un domaine de pratique spécifique, utilisez-le dans le cadre de la question. Les suggestions que vous recevrez devraient être plutôt bonnes.

Cadeau bonus : éviter les ennuis avec ChatGPT

OpenAI a été transparent sur les limites de ChatGPT. Son site Web indique : « GPT-4 présente encore de nombreuses limites connues que nous nous efforçons de résoudre, telles que les préjugés sociaux, les hallucinations et les invites contradictoires. » (Pour récapituler : GPT-4 est la version payante de ChatGPT et GPT-3.5 est la version gratuite.)

Quiconque a travaillé avec ChatGPT a été confronté à des préjugés (en grande partie dérivés de données historiques). Lorsque l’auteur Nelson a contesté son biais, ChatGPT s’est montré carrément désolé, s’excusant pour le biais et expliquant que les données historiques étaient connues pour provoquer un certain biais.

Nous avons tous entendu parler des hallucinations de l’IA. Nous avons rencontré de fausses affaires, de vrais juges désignés comme supervisant de fausses affaires, des livres, des articles et des liens qui n’existaient pas, de fausses allégations de conduite criminelle émanant de vraies personnes, et la liste est longue.

ChatGPT a une confiance totale dans ses réponses aux requêtes – et les avocats ont prouvé à maintes reprises qu’ils ne parviennent pas à vérifier une ressource aussi sûre d’elle.

À tout moment, ChatGPT semble plutôt confiant. Vous ne pouvez certainement pas demander à un menteur connu s’il dit la vérité. Vous devez donc valider les informations auprès d’autres sources réputées.

Comment valider les informations de ChatGPT ?

Du point de vue d’un avocat, la validation proviendra de sources juridiques réputées. ChatGPT vous recommande de consulter les sites Web officiels des tribunaux, Westlaw, LexisNexis et Bloomberg. Nous avons interrogé ChatGPT sur les avocats qui ne peuvent pas se permettre certaines ressources payantes et lui avons demandé pourquoi il n’avait pas recommandé Google Scholar.

À notre grand amusement, il s’est excusé d’avoir négligé le fait que certains avocats n’avaient peut-être pas accès à des ressources coûteuses, et il a affirmé que Google Scholar pourrait être une excellente ressource. Sans qu’on lui demande quoi que ce soit d’autre, ChatGPT a pris sur lui de proposer une liste à puces de la manière dont les avocats pourraient utiliser efficacement Google Scholar pour la validation. Nous avons trouvé très impressionnant qu’il offre des conseils, sans nous le demander.

Garde-corps pour l’utilisation de n’importe quelle IA

Comme l’ont conclu de nombreux experts, nous avons besoin de garde-fous pour assurer la sécurité lors de l’utilisation de l’IA. Dans de nombreux cabinets d’avocats, toutes sortes d’IA peuvent être utilisées. C’est ce qu’on appelle « l’IA fantôme » car, souvent, personne dans l’entreprise ne sait qui utilise quelle IA. La première étape consiste donc à créer une politique d’utilisation de l’IA :

Créez une politique pour une utilisation acceptable de l’IA. Cela inclurait évidemment la nécessité de vérifier les informations fournies par l’IA auprès d’une source faisant autorité. Il existe des modèles partout : commencez par le modèle et personnalisez-le pour votre cabinet d’avocats. Formez vos employés à l’utilisation de l’IA. Pour la plupart d’entre eux, l’IA est une vaste inconnue et ils tentent de déterminer comment elle peut les aider dans la pratique du droit. La formation à l’IA sera probablement courante en 2024. Assurez-vous de divulguer aux clients l’utilisation de l’IA par votre entreprise et d’obtenir le consentement pour l’utiliser. Si l’utilisation de l’IA réduit les heures de travail, cela doit être reflété sur la facture. Vous pouvez probablement compter sur vos clients qui vous interrogeront à ce sujet ! Assurez-vous de porter une attention particulière aux exigences légales et réglementaires. Il existe actuellement un nombre limité de telles exigences, mais elles vont se multiplier au cours des prochaines années.

Derniers mots : vérifier, vérifier, vérifier

Avoir des ennuis avec l’IA est facile : tout ce que vous avez à faire est d’ignorer les conseils ci-dessus. Si vous ne parvenez pas à vérifier la véracité des informations fournies par l’IA, vous risquez de vous attirer les foudres des juges, des clients et des collègues. Plus d’un avocat a reçu un feuillet rose pour défaut de validation. « Vérifiez, vérifiez, vérifiez » devrait être votre mantra.

Sharon D. Nelson est avocate en exercice et présidente de Sensei Enterprises, Inc. Elle est une ancienne présidente du Virginia State Bar, de la Fairfax Bar Association et de la Fairfax Law Foundation. Elle est co-auteur de 18 livres publiés par l’ABA. snelson@senseient.com.

John W. Simek est vice-président de Sensei Enterprises. Il est un professionnel certifié en sécurité des systèmes d’information (CISSP), un hacker éthique certifié (CEH) et un expert de renommée nationale en criminalistique numérique. Lui et Sharon fournissent des services de technologie juridique, de cybersécurité et d’investigation numérique depuis leur cabinet de Fairfax, en Virginie. jsimek@senseient.com.

Michael C. Maschke est le PDG/directeur de la cybersécurité et de la criminalistique numérique de Sensei Enterprises. Il est examinateur certifié EnCase et examinateur informatique certifié. mmaschke@senseient.com.

En savoir plus sur ChatGPT pour les avocats

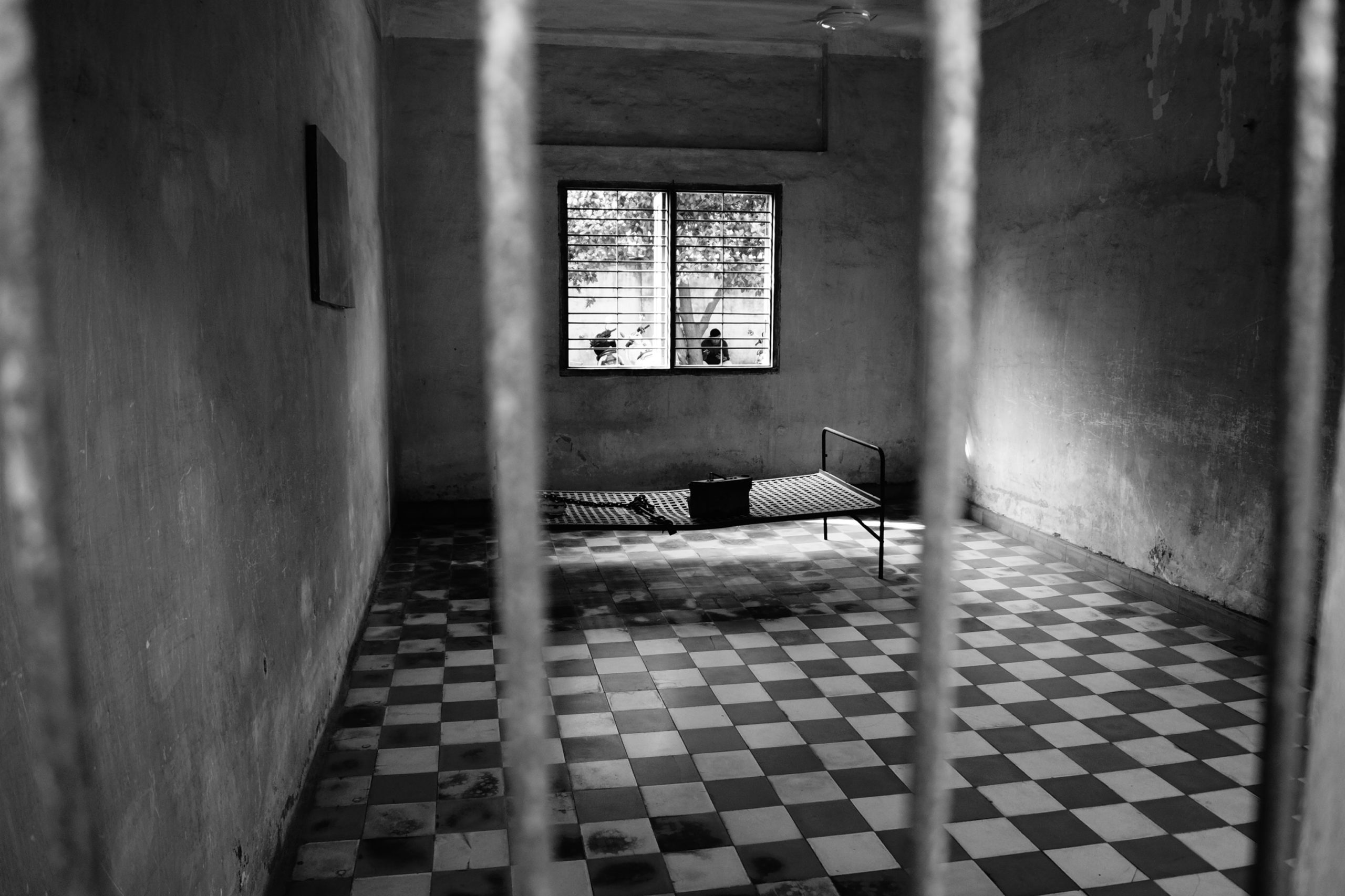

Image © iStockPhoto.com

Ne manquez pas nos conseils de gestion de cabinet au quotidien. Abonnez-vous à la newsletter gratuite de Attorney at Work ici >

%20SPW%20A.%20Coppens.jpg?h=f8fec600&itok=1130yyZK)