[ad_1]

Le Centre national pour les enfants disparus et exploités a récemment publié son Rapport CyberTipline 2023qui capture les principales tendances des rapports soumis par le public et les plateformes numériques sur les abus sexuels présumés sur des enfants exploitation. Chez Thorn, ces connaissances sont essentielles à nos efforts visant à défendre les enfants contre les abus sexuels et aux technologies innovantes que nous développons pour ce faire.

Cette année, deux thèmes clairs sont ressortis du rapport : les abus sexuels sur enfants restent un problème fondamentalement humain – un problème que la technologie aggrave considérablement. Et les technologies de pointe doivent faire partie de la solution à cette crise à l’ère numérique.

L’ampleur des abus sexuels sur les enfants continue de croître

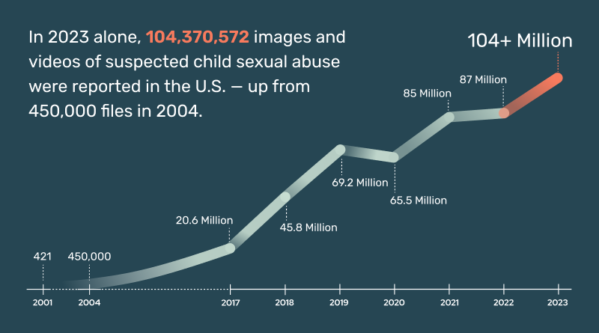

En 2023, CyberTipline du NCMEC a reçu un nombre stupéfiant de 36,2 millions de signalements de suspicion d’exploitation sexuelle d’enfants. Ces rapports comprenaient plus de 104 millions des dossiers de matériel suspecté d’abus sexuel sur enfant (CSAM) – photos et vidéos qui documentent l’abus sexuel d’un enfant. Ces chiffres devraient nous faire réfléchir immédiatement car ils représentent de vrais enfants subissant d’horribles abus. Ils soulignent la nécessité urgente d’une réponse globale.

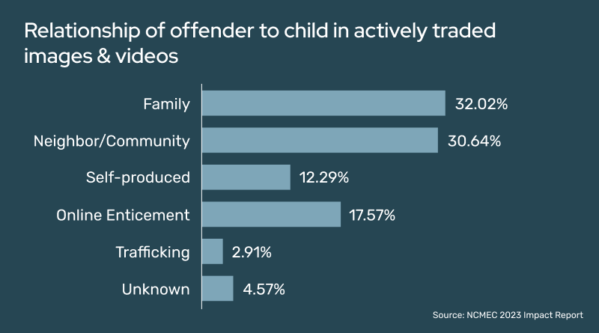

NCMEC Rapport d’impact, qui a été publié plus tôt cette année, a mis en lumière les créateurs d’une grande partie de ces CSAM, y compris des fichiers dont le programme d’identification des enfants victimes du NCMEC avait déjà connaissance. Malheureusement, pour près de 60 % des enfants déjà identifiés dans les CSAM distribués, les agresseurs étaient des personnes avec lesquelles les enfants devraient être en sécurité : les membres de la famille et les adultes de confiance au sein de la communauté (tels que les enseignants, les entraîneurs et les voisins) sont les plus susceptibles d’être derrière. Les CSAM circulent activement sur Internet aujourd’hui. Ces adultes exploitent leurs relations pour soigner et maltraiter les enfants dont ils ont la garde. Ils partagent, échangent ou vendent ensuite la documentation sur ces abus dans des communautés en ligne, et la diffusion de ce matériel revictimise l’enfant encore et encore.

Bien entendu, l’ampleur stupéfiante des abus et de l’exploitation sexuels des enfants dépasse les rapports présentés. Et les technologies modernes sont responsables de l’accélération la capacité des prédateurs à commettre des violences sexuelles contre des enfants.

Cela signifie que nous devons agir à grande échelle, en partie en créant et en utilisant des technologies de pointe pour accélérer la lutte contre les abus sexuels sur enfants sous tous les angles.

La technologie doit faire partie de la solution

L’efficacité et l’évolutivité de la technologie peuvent créer une force puissante et positive. Thorn reconnaît depuis longtemps l’avantage de l’IA et de l’apprentissage automatique (ML) pour identifier le CSAM. Notre solution Safer Predict utilise une IA prédictive de pointe pour détecter les CSAM inconnus circulant sur Internet ainsi que les nouveaux fichiers CSAM téléchargés en permanence. Il peut désormais également détecter les conversations potentiellement dangereuses – telles que la sextorsion et la sollicitation de personnes nues – entre de mauvais acteurs et des enfants, grâce à notre classificateur de texte. Ces solutions fournissent les outils essentiels nécessaires pour arrêter la propagation du CSAM et des abus en ligne.

De plus, les mêmes modèles d’IA/ML qui détectent les contenus pédopornographiques en ligne accélèrent également considérablement les efforts des forces de l’ordre dans les enquêtes sur les abus sexuels sur enfants. Alors que les agents effectuent un examen médico-légal de montagnes de preuves numériques, les classificateurs, comme celui de Safer Predict, utilisent des modèles d’IA pour automatiser la détection CSAM, ce qui permet aux agents de gagner un temps crucial. Cela aide les forces de l’ordre à identifier plus rapidement les enfants victimes afin de pouvoir les soustraire à des situations cauchemardesques.

Dans l’ensemble de l’écosystème de la sécurité des enfants, la vitesse et l’échelle comptent. Des technologies de pointe doivent être utilisées pour déjouer des comportements qui encouragent et encouragent les abus et les pipelines pour CSAM, tout en améliorant également les stratégies de prévention et d’atténuation. La technologie peut accélérer notre compréhension des menaces émergentes, aider les équipes de confiance et de sécurité à créer des environnements en ligne plus sûrs, améliorer les actions de réponse des lignes d’assistance téléphonique et accélérer l’identification des victimes.

En d’autres termes, le déploiement de la technologie dans toutes les facettes de l’écosystème de la sécurité des enfants sera nécessaire si nous voulons faire autre chose que d’apporter un arroseur de jardin lors d’un incendie de forêt.

Les entreprises technologiques jouent un rôle clé

De 2022 à 2023, les signalements d’abus et d’exploitation sexuels sur enfants au NCMEC ont augmenté de plus de 4 millions. Bien que cette augmentation soit corrélée à une augmentation des abus, cela signifie également que les plateformes font un meilleur travail de détection et de signalement du CSAM. Il s’agit d’un élément nécessaire de la lutte contre l’exploitation en ligne et nous félicitons les entreprises qui investissent dans la protection des enfants grâce à leurs services.

Pourtant, la réalité est que seule une petite partie des plateformes numériques soumettent des rapports au NCMEC. Chaque plateforme d’hébergement de contenu doit reconnaître le rôle qu’elle joue dans l’écosystème de la sécurité des enfants et la possibilité dont elle dispose pour protéger les enfants et sa communauté d’utilisateurs.

Lorsque les plateformes détectent l’exploitation sexuelle des enfants et l’exploitation sexuelle des enfants et soumettent des rapports au NCMEC, ces données peuvent offrir des informations pouvant conduire à l’identification des enfants et à leur mise hors de danger. C’est pourquoi il est essentiel que les plateformes soumettent des rapports de haute qualité contenant des informations clés sur les utilisateurs qui aident le NCMEC à identifier le lieu de l’infraction ou l’organisme d’application de la loi approprié.

De plus, l’interconnectivité d’Internet signifie que les abus ne restent pas sur une seule plateforme. Les enfants et les mauvais acteurs se déplacent de manière fluide dans les espaces : les abus peuvent commencer sur une plateforme et se poursuivre sur une autre. Le CSAM se propage également de manière virale. Cela signifie qu’il est impératif que les entreprises technologiques collaborent de manière innovante pour lutter contre les abus en un front uni.

Un problème humain aggravé par les technologies émergentes

L’année dernière, le NCMEC a reçu 4 700 signalements de CSAM ou d’autres contenus à caractère sexuel liés à l’IA générative. Bien que cela semble beaucoup – et c’est le cas – ces rapports ne représentent qu’une goutte d’eau dans l’océan par rapport au CSAM produit sans IA.

Les rapports croissants impliquant la génération AI devraient cependant déclencher la sonnette d’alarme. Tout comme Internet lui-même a accéléré les abus hors ligne et en ligne, l’utilisation abusive de l’IA peut constituer de graves menaces pour la sécurité des enfants. Les technologies d’IA facilitent plus que jamais la création de contenu à grande échelle, y compris le CSAM, ainsi que les textes de sollicitation et de toilettage. Le CSAM généré par l’IA va des adaptations par l’IA de matériels abusifs originaux à la sexualisation de contenus inoffensifs en passant par le CSAM entièrement synthétique, souvent formé sur le CSAM impliquant de vrais enfants.

En d’autres termes, il est important de se rappeler que les abus sexuels sur enfants restent un problème fondamentalement humain, qui touche les vrais enfants. Les technologies d’IA générative entre de mauvaises mains facilitent et accélèrent ces dommages.

Aux débuts d’Internet, les signalements d’abus en ligne étaient relativement peu nombreux. Mais de 2004 à 2022, ils sont passés de 450 000 signalements à 87 millions, aidés par le numérique. Pendant cette période, collectivement, nous n’avons pas suffisamment abordé la manière dont la technologie pouvait aggraver et accélérer les abus sexuels sur enfants.

Aujourd’hui, nous en savons beaucoup plus sur la manière dont les abus sexuels sur enfants se produisent et sur la manière dont la technologie est utilisée à mauvais escient pour nuire sexuellement aux enfants. Nous sommes mieux placés pour évaluer rigoureusement les risques que l’IA générative et d’autres technologies émergentes posent pour la sécurité des enfants. Chaque acteur de l’industrie technologique a la responsabilité de garantir la protection des enfants lors de la création de ces applications. C’est pourquoi nous avons collaboré avec All Tech Is Human et dirigé entreprises d’IA générative s’engager à respecter des principes visant à empêcher l’utilisation abusive de l’IA pour aggraver les préjudices sexuels contre les enfants.

Si nous ne parvenons pas à faire face aux impacts des technologies émergentes les yeux ouverts, nous risquons d’ouvrir la boîte de Pandore.

Ensemble, nous pouvons créer un monde plus sûr

De la sextorsion financière à l’incitation en ligne d’enfants à des actes sexuels, le rapport 2023 du NCMEC rend compte de la croissance continue de tendances inquiétantes à l’encontre des enfants. Mettre fin aux abus et à l’exploitation sexuels des enfants nécessitera une force encore plus puissante et à une plus grande échelle – une force qui nous oblige à considérer la technologie comme notre alliée.

C’est pourquoi Thorn continue de développer une technologie de pointe, d’élargir ses partenariats dans l’écosystème de la sécurité des enfants et de réunir davantage d’entreprises technologiques et de législateurs autour de la table pour leur donner les moyens d’agir sur cette question.

L’abus sexuel des enfants est un défi que nous peut résoudre. Lorsque les esprits les plus brillants innovent et travaillent ensemble, nous pouvons construire un monde plus sûr, dans lequel chaque enfant est libre d’être simplement un enfant.

[ad_2]

Source link