Notre capacité à télécharger du contenu sur nos applications préférées ou à discuter avec d’autres personnes en ligne fait partie de la manière dont nous socialisons avec nos communautés numériques. Pourtant, ces mêmes fonctionnalités sont également exploitées par des acteurs malveillants pour nuire aux enfants, par exemple pour solliciter, créer et partager du matériel pédopornographique ou même pour faire du sextorsion envers les enfants en ligne.

Les plateformes doivent mener une bataille difficile pour lutter contre cette utilisation abusive de leurs fonctionnalités. Mais il est essentiel qu’elles le fassent. Non seulement l’exploitation sexuelle des enfants en ligne met en danger les enfants et les utilisateurs des plateformes, mais l’hébergement de contenus d’abus sexuels sur mineurs est illégal pour les plateformes.

C’est pourquoi en 2019, Thorn a lancé notre solution Safer pour aider les plateformes d’hébergement de contenu à mettre fin à la propagation virale du CSAM et avec elle, à la revictimisation. Aujourd’hui, nous sommes ravis d’annoncer la prochaine étape de cet effort : une extension significative de nos capacités avec Safer Predict.

Le pouvoir de l’IA pour défendre les enfants

Notre solution Safer, désormais appelée Safer Match, propose une technologie appelée hachage et correspondance pour détecter les contenus d’abus sexuels sur mineurs connus, c’est-à-dire les contenus qui ont été signalés mais qui continuent de circuler en ligne. À ce jour, Safer a fait correspondre plus de 3 millions de fichiers d’abus sexuels sur mineurs, aidant ainsi les plateformes à stopper la propagation virale des contenus d’abus sexuels sur mineurs et la revictimisation qu’ils provoquent.

Avec Safer Predict, nos efforts vont encore plus loin. Cette solution basée sur l’IA détecte les images et vidéos CSAM nouvelles et non signalées et a jusqu’à présent classé près de 2 millions de fichiers comme potentiellement CSAM.

Nous sommes désormais fiers de vous annoncer que Safer Predict est désormais capable d’identifier les menaces potentiellement dangereuses. conversations qui incluent ou pourraient conduire à l’exploitation sexuelle des enfantsEn s’appuyant sur des modèles d’apprentissage automatique de pointe, Safer Predict permet aux plateformes de :

Élargissez votre champ de détection des contenus d’abus sexuels sur mineurs et de l’exploitation sexuelle des enfants

Identifier les préjudices liés au texte, y compris les discussions sur la sextorsion, les contenus CSAM auto-générés et l’exploitation potentielle hors ligne

Capacités de détection d’échelle efficaces

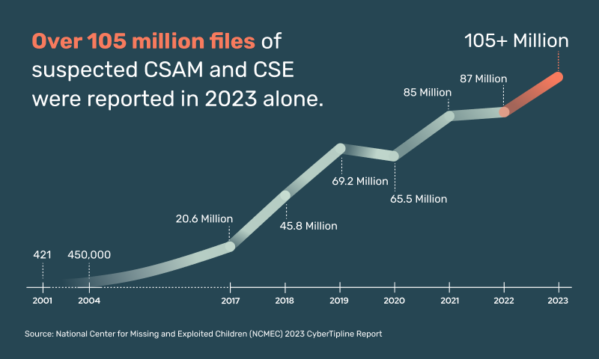

Pour comprendre l’impact des nouvelles fonctionnalités de Safer Predict, notamment en matière de texte, il est utile de saisir l’ampleur de l’exploitation sexuelle des enfants en ligne.

Le défi croissant de l’exploitation des enfants en ligne

Les abus et l’exploitation sexuels des enfants augmentent en ligne à un rythme alarmant :

Et en janvier 2024, Les sénateurs américains ont exigé Les dirigeants du secteur technologique prennent des mesures contre l’augmentation dévastatrice des abus sexuels sur mineurs sur leurs plateformes.

En réalité, les acteurs malveillants utilisent les réseaux sociaux et les plateformes d’hébergement de contenu pour exploiter les enfants et diffuser le matériel pédopornographique plus rapidement que jamais. Ils exploitent également les nouvelles technologies comme l’IA pour étendre rapidement leurs tactiques malveillantes.

Le hachage et la mise en correspondance sont essentiels pour résoudre ce problème, mais la technologie ne détecte pas l’exploitation basée sur du texte. Elle ne détecte pas non plus les contenus d’abus sexuels sur mineurs nouvellement générés, qui peuvent représenter un enfant victime d’abus actif. Les contenus d’abus sexuels sur mineurs textuels et nouveaux représentent des situations à enjeux élevés : les détecter peut fournir une plus grande opportunité pour les plateformes d’intervenir lorsqu’une situation d’abus active peut se produire et de la signaler au NCMEC.

Les technologies d’IA prédictives de Safer Predict permettent aux plateformes de détecter ces préjudices survenant sur leur plateforme. Ces efforts peuvent aider à découvrir des informations essentielles pour identifier les enfants dans des situations de maltraitance active et pour renforcer la capacité des forces de l’ordre à soustraire les enfants victimes de tout danger.

Modèles d’IA construits sur des données fiables

Même si l’IA semble être partout de nos jours, tous les modèles ne sont pas créés de la même manière. En matière d’IA, les données validées sont importantes, en particulier pour détecter les contenus pédopornographiques et l’exploitation sexuelle des enfants.

Les modèles de classification d’images et de vidéos basés sur l’apprentissage automatique de Thorn sont formés sur des contenus CSAM confirmés fournis par nos partenaires de confiance, notamment le NCMEC. En revanche, des outils de modération plus larges conçus pour différents types de préjudices pourraient simplement utiliser des données de reconnaissance d’âge combinées à de la pornographie pour adultes, ce qui diffère radicalement du contenu CSAM.

Les modèles de détection de texte de Safer Predict sont formés sur les messages :

Discussion sur la sextorsion

Demande, transaction et partage de contenus CSAM

Demander du contenu sexuel auto-généré par un mineur, ainsi que des mineurs discutant de leur propre contenu auto-généré

Discussion sur l’accès aux enfants et les sévices sexuels infligés aux enfants dans un contexte hors ligne

En entraînant les modèles de Safer Predict sur des contenus CSAM confirmés et des conversations réelles, les modèles sont capables de prédire la probabilité que des images et des vidéos contiennent des contenus CSAM et des messages contenant du texte lié à l’exploitation sexuelle des enfants.

Ensemble, Safer Match et Safer Predict fournissent des plateformes avec une détection complète du CSAM et de l’exploitation sexuelle des enfants, ce qui est essentiel pour protéger les enfants, en ligne et hors ligne.

Partenariat pour un Internet plus sûr

Chez Thorn, nous sommes fiers de disposer de la plus grande équipe d’ingénieurs et de data scientists au monde, exclusivement dédiée à la création de technologies permettant de lutter contre les abus et l’exploitation sexuelle des enfants en ligne. Face à l’émergence de nouvelles menaces, notre équipe travaille dur pour réagir, notamment en luttant contre l’augmentation des menaces de sextorsion grâce à la nouvelle solution de détection par SMS de Safer Predict.

La capacité de détecter des messages et des conversations potentiellement dangereux entre de mauvais acteurs et des enfants sans méfiance constitue un grand pas en avant dans notre mission de défendre les enfants et de créer un monde numérique plus sûr, où chaque enfant est libre d’être simplement un enfant.

%20SPW%20A.%20Coppens.jpg?h=f8fec600&itok=1130yyZK)